喂垃圾数据=毁模型?最新研究:AI 脑腐不可逆,清洗也救不了

大数据文摘出品

最近,德州农工大学与德州大学奥斯汀分校的研究团队,在论文中提出一个结论:大模型可能会“脑腐”。

他们称之为“LLM Brain Rot Hypothesis”,意指当模型长期暴露在低质量网络文本中时,其认知能力会持续退化,并表现出与人类“信息上瘾”相似的症状。

研究团队在论文中指出,这种退化不是临时的,而是深层、持久、且难以修复的结构性损伤。

与人类的“脑腐”类似,模型的症状包括注意力衰退、推理链断裂、长期记忆混乱、以及性格倾向扭曲。

他们的核心发现是:持续在垃圾数据上预训练,会让模型永久变笨。

在受污染的模型中,逻辑推理准确率下降超过20个百分点,长文本理解下降幅度可达40%。

甚至,在心理人格测试中,模型出现了“自恋”“精神病倾向”等特征。

实验如何验证“脑腐”:从推文到推理

论文设计了一个极具象征意义的实验:让模型“沉迷社交媒体”。

研究者从Twitter(现X平台)采集了上百万条推文,按两种方式划分“垃圾内容”。

第一种是M1:互动度维度——短且高热度的内容,被视为典型的“快感型垃圾”。

第二种是M2:语义质量维度——内容空洞、煽动性强、使用标题党词汇或夸张情绪的文字。

团队用这两类数据分别对四个主流开源模型(包括Llama3与Qwen系列)进行持续预训练,并以干净语料作为对照组。

结果令人震惊。在M1条件下,模型在ARC推理测试中的表现从74.9分骤降至57.2分,长文本检索任务RULER的得分则从84.4降至52.3。

也就是说,“越刷短内容,越失去思考能力。”

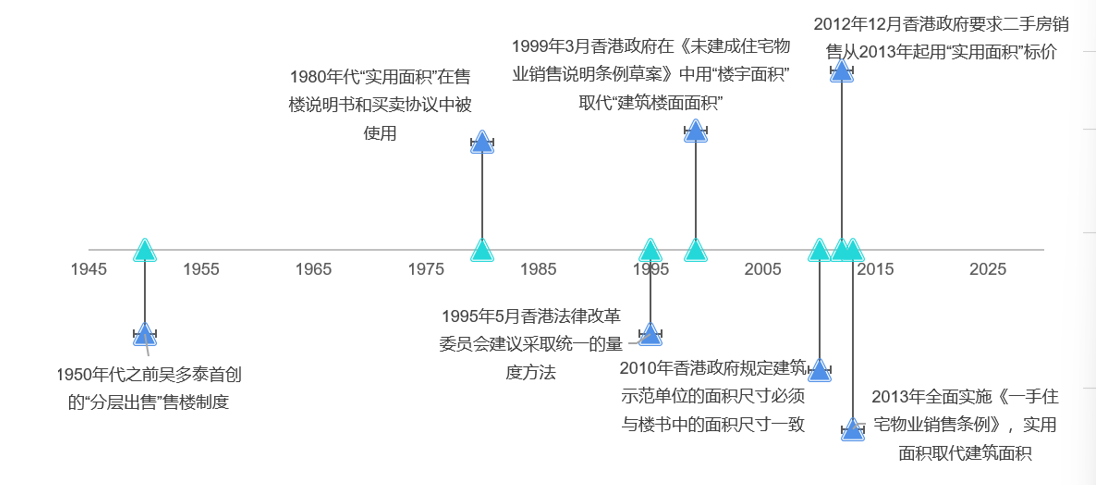

图注:数据显示“脑腐化”内容往往更短、更受欢迎但语义质量低,人类与GPT对语义质量的判断高度一致。

研究者将这种衰退模式称为“剂量响应”:垃圾数据比例越高,能力退化越明显。

更进一步,他们分析了模型的思考过程,发现最主要的“病灶”是,思维跳步(Thought-skipping)。

模型在推理时往往不再展开完整思考,而是直接跳过中间推理链,草率给出结论。

这种行为被称为“认知短路”,类似人类沉迷短视频后的专注力下降。

作者用四类基准(ARC、RULER、HH-RLHF/AdvBench、TRAIT)来评估大模型的推理、记忆与多任务、伦理规范及人格倾向等认知功能。

退化不可逆:清洗与微调都救不了

论文进一步分析了退化的内部模式。主要发现是,垃圾数据训练后模型出现推理链中断(thought-skipping)现象。

模型在回答问题时更倾向直接给出结论,而非展开逐步推理。

研究者使用GPT-4o-mini对思维链进行分类,发现超过70%的错误来自“无思考”或“思维跳步”,而非单纯逻辑错误。

这一现象与人类在高强度信息刺激下的“注意力割裂”表现相似,但研究者强调,该结果并非类比结论,而是统计规律。

随着“垃圾内容”比例上升,模型在推理、长上下文理解、伦理安全及人格稳定性等各项认知功能上普遍退化,验证了“脑腐化”效应。

团队还进行了剂量效应分析(dose–response),结果表明:垃圾数据比例与性能下降幅度成近线性关系。

随后,研究者尝试通过额外的指令微调与干净数据继续训练来“修复”模型。

即使增加五倍规模的清洁数据进行指令调优,模型仍未完全恢复至基线性能。

这说明所谓的“脑腐”效应可能不是格式错配,而是参数空间层面的结构漂移(representational drift)。

研究还测试了反思式推理(Reflective Reasoning)等无训练修复方法。

结果显示,使用外部强模型提供反馈(如GPT-4o-mini)能部分恢复推理链完整性,但无法完全修复性能差距。

团队据此提出,“模型认知衰退”可能在训练过程中被永久编码进参数分布中。

论文最后指出,这一发现将数据质量问题转化为训练安全问题(training-time safety)。

作者建议未来建立“模型认知健康检查”机制,用于监控预训练数据的组成与长期效果。

他们强调,本研究并未证明所有社交媒体数据均为有害样本,但结果提示,数据来源的复杂性与语义深度,可能直接决定模型的长期稳定性。

研究团队在论文结论中写道:“持续暴露于低质量文本会造成可验证的认知退化,这种退化具有持续性且难以逆转。”

这项研究提供了首次系统证据,说明数据质量不仅影响模型性能,也影响模型的内部认知结构。

它将“AI训练数据质量”从经验问题转变为可量化、可因果验证的科学议题。

作者呼吁,在大模型持续扩展的时代,数据筛选与长期维护应被视为认知安全的一部分。

注:头图AI生成

作者长期关注 AI 产业与学术,欢迎对这些方向感兴趣的朋友添加微信 Q1yezi,共同交流行业动态与技术趋势!

原标题:《喂垃圾数据=毁模型?最新研究:AI 脑腐不可逆,清洗也救不了》

阅读原文

本文为澎湃号作者或机构在上传并发布,仅代表该作者或机构观点,不代表的观点或立场,仅提供信息发布平台。申请澎湃号请用电脑访问http://renzheng.thepaper.cn。